A cosa servono i dissalatori lo sappiamo. Grosso modo.

Le vere domande da porci sono:

- perché servono

- quanto costa un impianto di dissalazione?

- quando costa un metro cubo di acqua dissalata?

- rispettano l’ambiente?

- servono veramente?

![]() Perché servono

Perché servono ![]() El Niño – La Niña

El Niño – La Niña ![]() Dissalatori nel mondo

Dissalatori nel mondo ![]() I processi di dissalazione

I processi di dissalazione ![]() Il costo

Il costo![]() La salamoia tossica frutto della dissalazione

La salamoia tossica frutto della dissalazione ![]() Conclusione

Conclusione

PERCHE’ SERVONO

Ecco cosa riporta il sito GreeMe in sintesi.

I cambiamenti climatici stanno mettendo in ginocchio le nostre risorse idriche.

Livelli di neve bassi senza precedenti sulle Alpi e la previsione di una carenza di risorse idriche nella regione del Mediterraneo: un mix perfetto che fa presagire il peggio.

Dopo un 2022 con la peggiore siccità dell’ultimo mezzo secolo, nel 2023 ci ritroviamo ad affrontare un’altra crisi che si prospetta ancora più grave e che già minaccia l’agricoltura, le fabbriche e l’approvvigionamento domestico.

Ecco cosa dice la FAO: “L’Italia avanza verso il deserto”

Dati alla mano, (quelli Fao), avremo una siccità terribile e l’acqua dal rubinetto non può più essere data per scontata.

Insomma niente di buono, quello che ci viene prospettato è una catastrofe mondiale.

Poi ecco che l’inverno del 2023 è stato il più freddo di sempre. Stati Uniti e Europa sommersi dalla neve.

A Febbraio, Marzo e Aprile 2024 abbiamo assistito ad alluvioni senza precedenti in tutto il mondo, dall’America del Sud, Europa (tra cui l’Italia), Arabia Saudita e perfino in Africa.

Miliardi e miliardi di metri cubi di acqua finiti in mare e nel sottosuolo.

Colpa del riscaldamento globale o è qualcosa di naturale?

Si può fare qualcosa recuperare almeno una parte di questo spreco d’acqua? ![]()

El Niño, La Niña.

Due fenomeni naturali della stessa natura che si replicano regolarmente nel tempo. Sono dispensatori di periodi di forte riscaldamento e siccità, alternati a periodi di forti precipitazioni e alluvioni. Questo il motivo per cui ne parliamo.

Dopo più di un anno in cui ha perversato El Niño con temperature record, dopo anni di rotture di marroni dei giornali e tv, ora arriva La Niña che farà precipitare le temperature.

Ce l’avevano cantata e suonata per bene questi fenomeni esperti del clima. Era tutta colpa dei carburanti fossili, via le auto a combustione, tutti a piedi o in bici o coi monopattini, via le caldaie a gas. Stavano distruggendo il pianeta.

Ora scopriamo che El Niño è stato ritenuto responsabile per aver spinto le temperature globali a livelli record, causando significative siccità in parti dell’Asia e del Sud America e portando a un inverno praticamente inesistente in Nord America.

Quante frottole ci hanno raccontato. Scioglimento dei ghiacciai e innalzamento dei mari di …. 68 metri per colpa delle automobili, delle caldaie a gas.

La Niña si manifesta con aumento della temperatura superficiale del mare al largo delle coste del Perù e dell’Ecuador e successivamente con fenomeni meteorologici particolarmente intensi, prima nelle zone circostanti e poi su scala planetaria.Le oscillazioni Meridionale del El Niño, comunemente nota come ENSO, è fondamentale per modelli climatici globali, che possono influenzare tutto, il clima, gli incendi boschivi, …. la siccità.

La genesi di questo fenomeno non è stata ancora completamente chiarita.

Poi arriva La Niña con ripercussioni, a cascata, in tutto il globo.

Nel mezzo ci sarà un periodo di transizione, uno stato neutro di cui non si conosce esattamente la sua durata.

La Niña è anche esso un evento naturale che colpisce una grossa fetta delle acque superficiali del Pacifico con temperature inferiori al normale, esattamente l’opposto del “fratello” piccolo famoso per valori termici più elevati anche di 3-4°C.

La Niña provocava cambiamenti in termini di precipitazioni abbondanti, alluvioni e soprattutto un abbassamento delle temperature in Europa.

Niente a che fare con i «mutati» cambiamenti climatici da effetto serra.

Tutto normale.

Sembra che il passaggio dovrebbe avvenire in questo periodo “aprile-giugno 2024” con le probabilità che La Niña si sviluppi entro giugno-agosto 2024 (60% di probabilità)”

Il riscaldamento globale da inquinamento di CO2 non è la causa della siccità. delle desertificazioni, per lo più una concausa. I deserti africani, asiatici non sono avvenuti lungo le ere geologiche per emissioni gassose dei cammelli.

La causa prima della siccità è proprio l’uomo che non riesce a porre rimedio, a trovare le giuste soluzioni.

Basterebbe, infatti, qualche diga e invaso in più e il problema idrico dovuto alla siccità sarebbe risolto.

Senza considerare che il 30% dell’acqua del nostro sistema idrico va disperso per inefficienza, incuria, scarsa manutenzione.

Eppure malgrado sia stato dato l’inizio dei lavori all’invaso della diga Saglioccia in Puglia per ultimare un’opera rimasta incompiuta per anni, qualcuno propone impianti di dissalazione, perfino in Liguria per fornire di acqua potabile la città di Genova, città del nord come Torino e Milano che sono a ridosso delle Alpi dove si potrebbero costruire invasi anche per uso agricole lungo la valle del Po. ![]()

DISSALATORI NEL MONDO

Ad oggi si contano nel mondo circa 16mila impianti in 177 Paesi principalmente nei paesi della penisola araba. Le particolari condizioni atmosferiche di queste terre dove l’acqua è un bene raro hanno portato i governi a investire in questa tecnologia realizzando alcuni degli impianti più grandi al mondo.

Uno di questi è sicuramente il Jebel Ali Desalination Plant negli Emirati Arabi, un progetto enorme all’interno del quale ha dato il suo contributo anche Fisia Italimpianti, la controllata del Gruppo Webuild (quella del Ponte sullo Stretto di Messina).

Come gli Emirati Arabi anche l’Arabia Saudita si è dotata di moderni impianti di dissalazione per assicurare l’approvvigionamento di acqua necessario al paese. Tra i grandi impianti del Paese, il Ras Al Khair, situato nella costa Est del Regno, produce acqua dolce per la capitale Riyadh dove viene trasportata attraverso un sistema di tubazioni lungo 535 chilometri.

Sempre in Arabia Saudita Fisia ha lavorato all’espansione del progetto Shoaiba III, nella costa occidentale del Paese, capace di produrre 250.000 metri cubi di acqua al giorno, che vengono utilizzati per assicurare acqua potabile a oltre un milione di abitanti distribuiti tra La Mecca, Jeddah e Taif.

Ce ne sono in India, Australia, anche in Europa.

Nel nostro Paese, gravata da una terribile dispersione idrica vengono prelevati oltre 33 miliardi di metri cubi di acqua all’anno, ma il 22% di questa va dispersa a causa di una rete idrica inefficiente.

Annualmente, in Italia il 55% circa della domanda proviene dal settore agricolo, il 27% da quello industriale e il 18% da quello civile. ![]()

I PROCESSI DI DISSALAZIONE

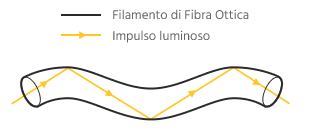

La dissalazione è il processo di rimozione della frazione salina da acque contenenti sale, in genere da acque marine, allo scopo di ottenere acqua a basso contenuto salino; l’acqua è poi impiegata spesso per uso alimentare, ma anche per uso industriale, come acqua di raffreddamento, ad uso agricolo.

Esistono diversi tipo di sistemi di desalinizzazione dell’acqua marina che sono sostanzialmente riassumibili in 3 famiglie:

- Dissalatori a evaporazione

- Dissalatori a permeazione o a osmosi inversa

- Dissalatori per scambio ionico

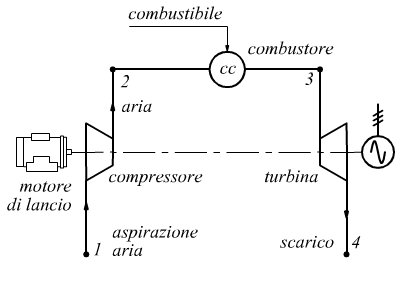

DISSALATORE A EVAPORAZIONE

Il funzionamento è abbastanza semplice ed intuibile. La dissalazione è ottenuta per evaporazione dell’acqua.

In questi impianti l’acqua viene riscaldata (un po’ come negli alambicchi degli esperimenti a scuola per ottenere acqua distillata). In basso rimane il sale (e gli scarti) e l’acqua evaporata e convogliata in un altro impianto (l’alambicco finale dell’esperimento a scuola) viene raffreddata e recuperata.

Si ottiene di solito un residuo a salinità più alta dell’acqua salmastra di alimentazione. La parte solida (essenzialmente cloruro di sodio) viene recuperata in forma cristallina. ![]()

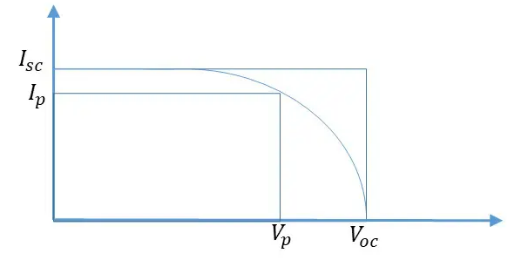

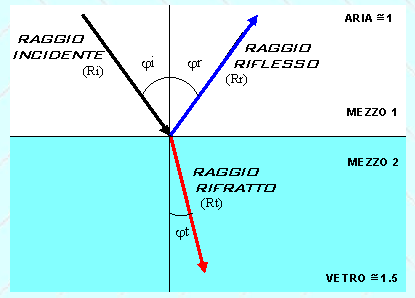

DISSALATORE A OSMOSI INVERSA

Se mettiamo a contatto due soluzioni separate da una membrana, la prima a bassa concentrazione salina e la seconda ad alta concentrazione salina, si assisterà ad un passaggio del solvente (acqua) dalla prima soluzione alla seconda.

L’acqua quindi inizierà a migrare sotto l’azione di una forza che si genera naturalmente: tale forza prende il nome di pressione osmotica.

Nell’osmosi inversa si utilizza un sistema di pompaggio che genera una pressione maggiore della pressione osmotica che si oppone ad essa; l’acqua quindi viene spinta contro la membrana ed è costretta a migrare dalla fase più concentrata a quella più diluita.

La membrana semipermeabile lascia passare solo le molecole di acqua trattenendo le altre sostanze chimiche. In altre parole si riesce ad isolare il solvente, ovvero l’acqua pura. La soluzione salina vedrà diminuire la sua concentrazione in NaCl.

Questa tecnica, nota come osmosi inversa, è molto più efficiente di una semplice filtrazione perché la membrana non funziona solo come trappola fisica, ma agisce anche al livello chimico con specifiche interazioni tra la membrana stessa e le sostanze chimiche.

Gli impianti industriali, chiaramente con soluzioni tecnologicamente diverse e membrane dalla corretta porosità (inferiore a 1 nm), sfruttano questo principio.

Al fine di osservare un flusso di acqua priva di sali dalla soluzione concentrata a quella diluita è necessario imporre una pressione al di sopra della prima, al fine di invertire la direzione del flusso osmotico.

È chiaro che, affinché un processo di osmosi inversa possa avvenire, è necessario fornire energia al sistema (sotto forma di pressione in testa alla soluzione più concentrata, fino a 100 bar in impianti industriali) per cui, a seconda della fonte energetica utilizzata (fonti fossili o fonti rinnovabili), l’impatto ambientale dell’intero processo può essere più o meno marcato. ![]()

DISSALATORI PER SCAMBIO IONICO

La dissalazione per scambio ionico viene ottenuta mediante rimozione degli ioni (sodio) Na+ e (cloruro) Cl- su resine e quindi portare a una netta diminuzione della concentrazione salina dell’acqua.

La soluzione marina viene fatta passare all’interno di una cella nella quale sono fissate due diversi tipi di membrane polimeriche disposte alternativamente e in gran numero.

L’attraversamento degli ioni attraverso le membranous è resa possibile da una differenza di potenziale.

La membrana cationica si lascia passare dagli ioni Na+ ma non dagli ioni Cl– ; viceversa la membrana anionica si lascia passare dagli ioni Cl– ma non dagli ioni Na+

Il processo avviene in comparti separati.

Questi sistemi risultano inadatti a trattare grandi volumi o flussi di acque eccessivamente ricche di sali. Il processo è inoltre un processo discontinuo poiché una volta scambiati tutti gli ioni H+ e OH– inizialmente presenti sulla resina, questa deve essere rigenerata. ![]()

IL COSTO

Il costo degli impianti varia molto. dipende dal tipo e dimensione del dissalatore installato. La realizzazione di duello di Dubai, uno fra i più grandi al mondo, ha avuto un costo di 3,5 miliardi di euro.

A questo va aggiunto il costo della energia che non è una variabile fissa.

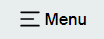

E’ stato stimato che costo dell’acqua desalinizzata si attesta infatti sui 2-3 fino a 5 euro al metro cubo (un metro cubo corrisponde mille litri).

Facciamo due conti:

- Le lavatrici da 8 kg consumano circa 40/50 litri d’acqua per ogni ciclo.

- Lavastoviglie. In base ai modelli dell’elettrodomestico, si possono consumare tra i 6 e i 15 litri d’acqua per ciclo, a seconda del programma scelto.

- Doccia. Ogni minuto scendono dal miscelatore circa 16 litri d’acqua. Questo significa che per una doccia di 5 minuti si consumano fino a 80 litri di acqua. Se la doccia dura 10 minuti si arriva a 160 litri, con una doccia di un quarto d’ora invece si possono addirittura superare i 240 litri.

Sinteticamente possiamo dire che ogni italiano consuma in media dai 130 ai 140 litri di acqua potabile al giorno con punte (in estate) che sfiorano addirittura i 300 l/g.

Se consideriamo 200 l/g, il costo giornaliero dell’uso dell’acqua dissalata è 5*200/1000 =1 euro al giorno, pari a 365 euro/anno,

Da una mia fattura di fornitura idrica:

MC = 86

Importo = 202.46 € (+quota fissa, + fognatura, +depurazione, +iva)

Importo acquedotto = 114.43 € (costo consumo materia prima)

Costo MC da bolletta = 2,35 €

Costo MC acquedotto da bolletta = 0.75 €

Comunque la vogliamo vedere, con o senza il costo degli impianti, l’acqua dissalata è un lusso che se lo possono permettere solo paesi come l’Arabia Saudita, Emirati Arabi.

Roba per ricchi.

Ovviamente anche altri paesi: a caro prezzo. ![]()

LA SALAMOIA TOSSICA FRUTTO DEI DISSALATORI

Ben vengano gli studi e le tecnologie per ottimizzare i nostri vari processi industriali, e ben vengano anche i dissalatori, ma su questi bisogna fare qualche ulteriore riflessione.

Nel processo di dissalazione dell’acqua marina per osmosi inversa, si ottiene un prodotto di scarto: la salamoia.

La salamoia, tecnicamente, è considerata uno scaro industriale, una scoria perché genera altro sale in gran quantità e metalli vari.

Di conseguenza, le conseguenze legate allo smaltimento di tale sostanza sono diverse e problematiche.

Uno studio commissionato dall’Onu evidenzia come per ogni litro di acqua desalinizzata si registri un residuo di 1,5 litri di salamoia, a concentrazione variabile, in funzione della salinità dell’acqua di partenza. Ciò vuol dire che, a livello globale, a fronte dei 95 milioni di metri cubi di acqua dolce, gli impianti di desalinazione producono anche 142 milioni di metri cubi di salamoia ipersalina al giorno.

E, nell’arco di un anno, la salamoia prodotta sarebbe sufficiente a coprire mezza Italia sotto 30 centimetri di melma caustica.

Il corretto smaltimento per ora è assai costoso e può arrivare fino al 33% dei costi operativi di un impianto.

Quale soluzione?

Per buona pace degli ambientalista la salamoia viene scaricata direttamente in mare.

Com’è facile intuire la salamoia smaltita in mare altera la salinità dell’acqua in prossimità delle coste e compromette l’ambiente marino per la elevata salinità, sia perché contengono sostanze chimiche tossiche provenienti dagli antivegetativi e dagli antincrostanti usati negli impianti di dissalazione.

Eppure, malgrado questi gravi inconvenienti legati allo smaltimento delle scorie c’è chi dice: «L’uso di acqua salina ha già dimostrato notevoli vantaggi commerciali, sociali e ambientali».

Ambientali?

Come dire che smaltire le bottigliette di plastica in mare ha comunque contribuito ai vantaggi commerciali, sociali e ambientali, dell’uso della plastica. ![]()

CONCLUSIONE

Malgrado le grandi potenzialità, occorre tener presente come i costi di produzione di acqua dissalata siano, ancora oggi, di gran lunga più elevati di quelli connessi al prelievo da fonte tradizionale. Roba per paesi ricchi o disperati.

Facciamo tanta attenzione alla CO2 scaricata in aria, e poi inquiniamo gli oceani con tanta leggerezza scaricando in mare gli scarti altamente inquinanti e pericolosi della dissalazione.

Eppure abbiamo la soluzione sotto il naso con il recupero delle acque piovane.

I romani la andavano a cercare dove c’era e la trasportavano con acquedotti lunghi chilometri e chilometri. E noi non siamo in grado di costruire invasi o dighe per portare l’acqua dove serve con condutture tipo metanodotti.

Il mio pensiero va alla regione Lombardia dove vogliono costruire un dissalatore per fornire Milano di acqua potabile quando lì dietro ci sono le Alpi. Il mio pensiero va alla Sicilia, dove pioverà poco, ma quel poco lo lasciamo disperdere. Il mio pensiero va alla dispersione idrica colabrodo delle nostre condutture.

E’ costituita essenzialmente da tubazioni che possono essere realizzate in metallo o calcestruzzo armato. Queste, generalmente, sono costruite all’interno della montagna (in galleria) o possono scorrere anche all’esterno sul crinale della stessa. All’imbocco, sono munite di organi di chiusura e di sicurezza che servono a regolare la portata dell’acqua, e alla base le paratoie di intercettazione delle acque che hanno garantiscono il funzionamento delle turbine filtrando o rallentando la spinta dell’acqua. Ancora più in basso sono posti appositi organi di regolazione, connessi direttamente con le turbine che, hanno lo scopo di regolare la portata dell’acqua.

E’ costituita essenzialmente da tubazioni che possono essere realizzate in metallo o calcestruzzo armato. Queste, generalmente, sono costruite all’interno della montagna (in galleria) o possono scorrere anche all’esterno sul crinale della stessa. All’imbocco, sono munite di organi di chiusura e di sicurezza che servono a regolare la portata dell’acqua, e alla base le paratoie di intercettazione delle acque che hanno garantiscono il funzionamento delle turbine filtrando o rallentando la spinta dell’acqua. Ancora più in basso sono posti appositi organi di regolazione, connessi direttamente con le turbine che, hanno lo scopo di regolare la portata dell’acqua.